bundlefusion

bundlefusion

# 论文

# 摘要

一般重建结果比较好的方法都需要几个小时的离线处理。最近在线重建的效果还没那么好,有以下问题

- 需要几分钟的处理,不能达到实时;

- 脆弱的跟踪模型,导致跟踪失败;

- 仅支持基于点的非结构化表示,这限制了扫描质量和适用性。

我们消除了对时间跟踪的严重依赖,而是不断定位到全局优化的帧

# 介绍

大规模实时3D重建问题需要满足以下条件

高质量的表面模型

我们需要一个单一的纹理和无噪点 3D 场景模型,可由标准图形应用程序使用。 这需要一个可以模拟连续表面而不是离散点的高质量表示。

可扩展性

全局模型一致性

随着规模的发函,需要纠正姿态漂移和估计误差。

鲁棒的相机跟踪

在特征不明显的区域可能跟踪失败,需要有重定位能力。许多先有的方法是基于与前一阵的接近度,从而限制了相机快速运动。我们就需要在不依赖时间连贯性的情况下的稳健的方法重定位。

即时模型更新

根据最新的姿态估计更新模型。

由于我们全局关联每个 RGB-D 帧,因此可以隐式且连续地处理回环,从而无需任何显式回环检测。

# 方法概述

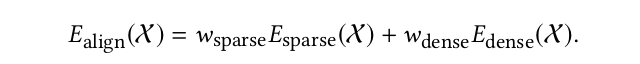

我们使用一组稀疏特征对应来获得粗略的全局对齐,因为稀疏特征固有地提供了回环检测和重新定位。然后通过优化密集的光度和几何一致性来细化这种对齐方式。

提取SIFT关键点,和以前所有帧进行匹配,并且严格的取出无匹配。

使用过滤后的关联,分层地局部到全局的位姿优化方法,在第一层,连续n帧(时间)组成一个chunk,在块内进行局部位姿优化。在第二层,所有的chunk相互关联进行全局优化。这种优化策略减少了未知量保证大范围重建。

为了使用改进的估计来跟新帧的位姿,使用新的实时分离步骤移除旧位姿的RGB-D图像,并在新位姿处重新整合。

# 寻找特征关联

对于新来的每一帧,提取SIFT特征,和以前所有帧进行匹配。之后筛选没两帧之间的匹配,取出匹配,并生成有效的成对关联的列表,作为全局位姿优化的输入。

# 去除两帧之间的关联

为了最小化外点,根据几何和光度一致性过滤检测到的成对对应集。在进行优化后算出一个残差,如果大于某个值,就移除这两帧之间所有的匹配,另外,如果某一帧与任何一帧都没有关联,则称为无效帧。

# 去除关键点误匹配

当前关联Pcur,Qcur,对于新添加的关联,p,q,计算出一个变换,使得Pcur, Qcur的RMSD最小。之后计算Pcur,Qcur的一些有关误差的数,如果大于一个阈值,贼认为系统是不稳定的,那么就移除这些关联,直到这不够计算出一个变换。如果计算不出一个变换,那么就把这两帧之间的所有关联移除。

# 通过表面过滤

检查特征跨越的表面是否足够大,因为跨越太小的尺寸的关联会引起歧义。对于每组3D点,我们将它们投影到由它们的两个主轴方向(可以用中心距和重心求出)给定的平面中,表面积由生成的投影点的2D定向边界框给定。如果跨越的区域不足多少平米,则该组匹配被丢弃。

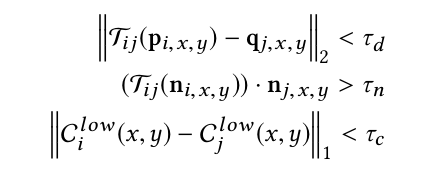

# 密集验证

以上式子都通过,就添加这关联到有效的关联集中,这之后用来做位姿优化。如果两帧之间关联数量大于一定值,则只使用帧间匹配来估计位姿。

# 分层优化

在输入的图像序列中,连续n帧组成一个chunk。在底层优化中,在一个块内进行局部对齐。在第二层,每一块的第一帧,作为这个块的关键帧,全局优化就是,对齐这些关键帧。

# 块内局部对齐

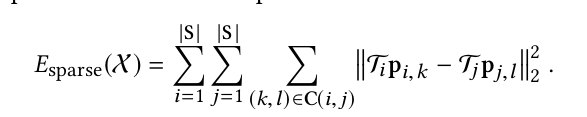

基于输入RGB-D流中连续11个帧,组成一个块,相邻的块重叠1帧。局部位姿优化是,计算与参考帧(块的第一帧)最优的相对位姿。优化的方法是,首先是上面的寻找特征关联,并且使用能量函数

在离散的匹配项,最小化S中所有帧对,所有关联的特征,投影到世界坐标系,的差。

C(i, j)是第i帧和第j帧关联的特征。

之后对块进行密集验证,如果重投影误差大于阈值,则丢弃这个块。

# 关键帧优化

一旦一个块完成优化,那么就定义块内第一帧作为关键帧。获得一个关键帧特征集,一旦获得关键帧特征集,就丢弃块数据。

# 全局块间优化

一旦一个关键帧没有找到一个以前的帧作为匹配,那么就视为无效帧,之后可以恢复。和局部块内优化一样,使用离散项和密集项来优化全局位姿。

# 参考文献

# 基于非结构化点的表示

P. Henry, M. Krainin, E. Herbst, X. Ren, and D. Fox. 2010. RGB-D mapping: Using depth cameras for dense 3D modeling of indoor environments. In Proc. Int. Symp. Experimental Robotics, Vol. 20. 22–25.

Maik Keller, Damien Leoch, Martin Lambers, Shahram Izadi, Tim Weyrich, and Andreas Kolb. 2013. Real-time 3D Reconstruction in Dynamic Scenes using Point-based Fusion. In Proc. 3DV. IEEE, 1–8.

T. Weise, T. Wismer, B. Leibe, and L. Van Gool. 2009. In-hand scanning with online loop closure. In Proc. ICCV Workshops. 1630–1637.

T. Whelan, S. Leutenegger, R. F. Salas-Moreno, B. Glocker, and A. J. Davison. 2015. ElasticFusion: Dense SLAM Without A Pose Graph. In Proc. RSS. Rome, Italy.

# 基于2.5D深度图

Maxime Meilland, Andrew Comport, and others. 2013. On unifying key-frame and voxel-based dense visual SLAM at large scales. In Proc. IROS. IEEE, 3677–3683.

P. Merrell, A. Akbarzadeh, L. Wang, P. Mordohai, J.M. Frahm, R. Yang, D. Nister, ´ and M. Pollefeys. 2007. Real-time visibility-based fusion of depth maps. In Proc. ICCV. 1–8.

# 基于高度场

David Gallup, Marc Pollefeys, and Jan-Michael Frahm. 2010. 3D reconstruction using an n-layer heightmap. In Paern Recognition. Springer, 1–10.

# 基于占用网格的体积

Alberto Elfes and Larry Mahies. 1987. Sensor integration for robot navigation: combining sonar and stereo range data in a grid-based representataion. In Decision and Control, 1987. 26th IEEE Conference on, Vol. 26. IEEE, 1802–1807.

Kai M Wurm, Armin Hornung, Maren Bennewitz, Cyrill Stachniss, and Wolfram Burgard. 2010. OctoMap: A probabilistic, exible, and compact 3D map representation for robotic systems. In Proc. ICRA, Vol. 2.

# 基于隐式曲面

Brian Curless and Marc Levoy. 1996. A volumetric method for building complex models from range images. In In Proc. SIGGRAPH. ACM, 303–312.

A. Hilton, A. Stoddart, J. Illingworth, and T. Windea. 1996. Reliable surface reconstruction from multiple range images. JProc. ECCV (1996), 117–126.

# 基于TSDF(隐式截断符号距离)

Nicola Fioraio, Jonathan Taylor, Andrew Fitzgibbon, Luigi Di Stefano, and Shahram Izadi. 2015. Large-Scale and Dri-Free Surface Reconstruction Using Online Subvolume Registration. Proc. CVPR (June 2015).

Simon Fuhrmann and Michael Goesele. 2014. Floating Scale Surface Reconstruction. In Proc. SIGGRAPH.

Marc Levoy, Kari Pulli, Brian Curless, Szymon Rusinkiewicz, David Koller, Lucas Pereira, Ma Ginzton, Sean Anderson, James Davis, Jeremy Ginsberg, and others. 2000. e digital Michelangelo project: 3D scanning of large statues. In In Proc. SIGGRAPH. ACM Press/Addison-Wesley Publishing Co., 131–144.

# 最近最突出的例子是 KinectFusion [20, 34],其中展示了较小场景的实时体积融合。

S. Izadi, D. Kim, O. Hilliges, D. Molyneaux, R. Newcombe, P. Kohli, J. Shoon, S. Hodges, D. Freeman, A. Davison, and A. Fitzgibbon. 2011. KinectFusion: Realtime 3D reconstruction and interaction using a moving depth camera. In Proc. UIST. 559–568.

Richard A Newcombe, Shahram Izadi, Otmar Hilliges, David Molyneaux, David Kim, Andrew J Davison, Pushmeet Kohli, Jamie Shoon, Steve Hodges, and Andrew Fitzgibbon. 2011. KinectFusion: Real-time dense surface mapping and tracking. In Proc. ISMAR. 127–136.

# 用于体积融合的实时高效数据结构。

Jiawen Chen, Dennis Bautembach, and Shahram Izadi. 2013. Scalable real-time volumetric surface reconstruction. ACM TOG 32, 4 (2013), 113.

Maik Keller, Damien Leoch, Martin Lambers, Shahram Izadi, Tim Weyrich, and Andreas Kolb. 2013. Real-time 3D Reconstruction in Dynamic Scenes using Point-based Fusion. In Proc. 3DV. IEEE, 1–8.

M. Nießner, M. Zollhofer, S. Izadi, and M. Stamminger. 2013. Real-time 3D ¨ Reconstruction at Scale using Voxel Hashing. ACM TOG (2013).

F Reichl, J Weiss, and R Westermann. 2015. Memory-Ecient Interactive Online Reconstruction From Depth Image Streams. In Computer Graphics Forum. Wiley Online Library

H. Roth and M. Vona. 2012. Moving Volume KinectFusion. In Proc. BMVC

F. Steinbruecker, J. Sturm, and D. Cremers. 2014. Volumetric 3D Mapping in RealTime on a CPU. In 2014 IEEE International Conference on Robotics and Automation (ICRA). Hongkong, China.

T Whelan, H Johannsson, M Kaess, J Leonard, and J McDonald. 2012. Robust Tracking for Real-Time Dense RGB-D Mapping with Kintinuous. Technical Report. ery date: 2012-10-25.

M. Zeng, F. Zhao, J. Zheng, and X. Liu. 2012. Octree-based Fusion for Realtime 3D Reconstruction. Graphical Models (2012).

Yizhong Zhang, Weiwei Xu, Yiying Tong, and Kun Zhou. 2015. Online structure analysis for real-time indoor scene reconstruction. ACM Transactions on Graphics (TOG) 34, 5 (2015), 159.

# 通过优化整个位姿轨迹来得到全局一致的模型

Sungjoon Choi, Qian-Yi Zhou, and Vladlen Koltun. 2015. Robust Reconstruction of Indoor Scenes. Proc. CVPR (June 2015).

Hao Li, Etienne Vouga, Anton Gudym, Linjie Luo, Jonathan T Barron, and Gleb Gusev. 2013. 3D self-portraits. ACM TOG 32, 6 (2013), 187.

Qian-Yi Zhou and Vladlen Koltun. 2013. Dense scene reconstruction with points of interest. ACM Transactions on Graphics (TOG) 32, 4 (2013), 112.

Qian-Yi Zhou and Vladlen Koltun. 2014. Color map optimization for 3D reconstruction with consumer depth cameras. ACM Transactions on Graphics (TOG) 33, 4 (2014), 155.

Qian-Yi Zhou, Steven Miller, and Vladlen Koltun. 2013. Elastic fragments for dense scene reconstruction. In Computer Vision (ICCV), 2013 IEEE International Conference on. IEEE, 473–480

# 实时单目RGB方法

# 稀疏

Georg Klein and David Murray. 2007. Parallel Tracking and Mapping for Small AR Workspaces. In Proc. ISMAR. Nara, Japan

# 半稠密

Jakob Engel, Jurgen Sturm, and Daniel Cremers. 2013. Semi-dense visual odometry for a monocular camera. In Proc. ICCV. IEEE, 1449–1456.

Christian Forster, Matia Pizzoli, and Davide Scaramuzza. 2014. SVO: Fast semidirect monocular visual odometry. In Proc. ICRA. IEEE, 15–22.

# 直接法

J. Engel, T. Schops, and D. Cremers. 2014. LSD-SLAM: Large-Scale Direct Monoc- ¨ ular SLAM. In European Conference on Computer Vision.

Maxime Meilland, A Comport, Patrick Rives, and INRIA Sophia Antipolis Mediterran ´ ee. 2011. Real-time dense visual tracking under large lighting varia- ´ tions. In Proc. BMVC, Vol. 29.

# 位姿图优化

Rainer Kummerle, Giorgio Grisei, Hauke Strasdat, Kurt Konolige, and Wolfram ¨ Burgard. 2011. g 2 o: A general framework for graph optimization. In Proc. ICRA. IEEE, 3607–3613.

# 捆绑调整

Bill Triggs, Philip F McLauchlan, Richard I Hartley, and Andrew W Fitzgibbon. 2000. Bundle adjustmen, a modern synthesis. In Vision algorithms: theory and practice. Springer, 298–372

MonoFusion [38] 通过密集体积融合增强了稀疏 SLAM 束调整,在小规模场景中显示出令人信服的单目结果。 实时 SLAM 方法通常首先逐帧估计位姿,然后在后台线程中执行校正(运行速度低于实时速率;例如,1Hz)。

Vivek Pradeep, Christoph Rhemann, Shahram Izadi, Christopher Zach, Michael Bleyer, and Steven Bathiche. 2013. MonoFusion: Real-time 3D reconstruction of small scenes with a single web camera. In Proc. ISMAR. 83–88.

相比之下,DTAM [35] 使用帧到模型跟踪的概念(来自 KinectFusion [20, 34])直接从重建的密集 3D 模型估计姿势。 这省略了校正步骤的需要,但显然不能扩展到更大的场景。

Richard A. Newcombe, Steven J. Lovegrove, and Andrew J. Davison. 2011. DTAM: Dense Tracking and Mapping in Real-time. In Proc. ICCV. 2320–2327.

# ICP

P.J. Besl and N.D. McKay. 1992. A method for registration of 3-D shapes. IEEE Trans. PAMI 14, 2 (1992), 239–256.

S. Rusinkiewicz and M. Levoy. 2001. Ecient variants of the ICP algorithm. In Proc. 3DIM. 145–152.